robots.txt 文件一定要放在根目录,文件名必须得小写,文件格式必须是文本。 还有别忘记robot后面还有个复数S .

我相信许多Seoers 不经常注意这些小细节,到实在要写robots文件去禁止一些爬寻才开始百度写法的。

robots.txt的一些影响:

1)页面或者分类文件夹禁止爬寻后,页面的链接不会传递权重给其它页面,一般禁止页面后,在谷歌搜索这个页面或分类的时候会出现以下这个提示。

2) 谷歌的搜索结果不再出现这个被禁止的页面

下面来看下robots.txt 的语法:

英语需要语法,需要遵循规则,反而其他一切东西都是这样的。

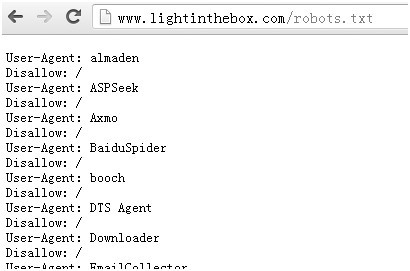

首先,指定一个蜘蛛名称 googlebot ,接着指定一个行为。蜘蛛通user –agent 分辨,指定的行为需要放在这些的下面一行。

1. No index :(以前索引的会删除掉) 屏蔽搜索引擎而且不索引页面。 这个一般少用,一般都不会说要删除已经收录的索引。而且不是各大引擎们都不是很支持这个语法

2. Disallow : 只是屏蔽蜘蛛访问的页面

以下细节,SEOER需要注意了:

user –agent 与Disallow 之间要用一个空行隔开,看下兰亭的写法

robots.txt 文件中可以用# 代表注释 。但是这个很少人用,没事没注释,免得别人知道你的意图。

目录名或者文件名的大小写会影响搜索引擎的判断,假如你的在robots.txt中写大写,但是真正的目录是小写的 那你就要注意了。

User-agent :Googlebot

Disallow:

允许谷歌蜘蛛去任何地方

为了更详细的参考说明,推荐看www.robotstxt.org/orig.html

修改这个文件要很小心,一个简单的拼写导致整个站点都不能让蜘蛛爬行的话,那就等吃鱿鱼了

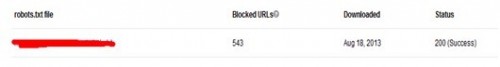

最后还告诉你个小细节: 在webmaster里面的 Block URLS 可以看到你的文件状态是否成功

543 代表有这么多链接被屏蔽了 ,200状态代表成功了

你喜欢蜘蛛吗?哈··